Jede statistische Analyse braucht Daten. Doch wie werden Daten überhaupt gesammelt? Und wie wird sichergestellt, dass sie verlässlich und aussagekräftig sind? Ein Einblick in die Methoden der Datenerhebung, die Rolle der Statistik und die damit verbundenen Herausforderungen.

Jede statistische Analyse braucht Daten. Doch wie werden Daten überhaupt gesammelt? Und wie wird sichergestellt, dass sie verlässlich und aussagekräftig sind? Ein Einblick in die Methoden der Datenerhebung, die Rolle der Statistik und die damit verbundenen Herausforderungen.

Der vorliegende Beitrag entstand 2023 im Rahmen der Sommerakademie «Stupid Statistics?!? Durchblick behalten im Daten-Dschungel der Gegenwart» der Schweizerischen Studienstiftung und wurde redaktionell begleitet von Reatch. Der Beitrag gibt die persönliche Meinung der Autorin wieder und entspricht nicht zwingend derjenigen von Reatch oder der Schweizerischen Studienstiftung. Erstmals erschienen im Reatch-Blog.

In der Schweiz beträgt das Durchschnittsalter knapp 43 Jahre, über 5.5 Millionen Menschen leben in Städten und gut 3.5 Millionen Menschen sind verheiratet. Diese und weitere Informationen über die Schweizer Bevölkerung liefert das Bundesamt für Statistik (BfS) Jahr für Jahr. Ein wesentliche Rolle spielt dabei die Volkszählung, die detaillierte Informationen über die Bevölkerung liefert. Dabei gibt es verschiedene Formen von Daten zu unterscheiden:

- Primär- vs. Sekundärdaten: Primärdaten werden neu und für einen speziellen Zweck gesammelt, während Sekundärdaten bereits bestehende Daten nutzen. Die Volkszählung des BfS sammelte früher vor allem Primärdaten, indem Einwohner und Unternehmen direkt befragt wurden. Mittlerweile greift der Zensus aber auch auf bereits vorhandene Sekundärdaten aus Einwohnerregistern, Bundespersonenregistern oder Gebäude- und Wohnungsregister zurück, was den Aufwand und die Kosten erheblich reduziert.

- Quantitative vs. qualitative Daten: Quantitative Daten, wie z.B. das Alter von Personen, lassen sich in Zahlen ausdrücken, während qualitative Daten komplexere Informationen in Form von Texten oder Bildern erfassen. Im Fall der Volkszählung werden hauptsächlich quantitative Daten erhoben, wie beispielsweise die Anzahl der Personen in einem Haushalt, das Alter, das Geschlecht und andere personenbezogene Daten.

- Systematische vs. unsystematische Erfassung: Daten können ferner systematisch erhoben werden, d.h. mittels exakter Vorgaben bezüglich Art und Weise, Zeit, Ort, etc. der Datenerhebung, oder unsystematisch, wobei nur grobe Vorgaben existieren und der Fokus auf die Gesamtsituation und hohe Flexibilität gelegt wird. Im Fall der Volkszählung erfolgt die Datenerhebung systematisch. Es gibt klare Vorgaben für die Art der Informationen, die gesammelt werden müssen: den Zeitpunkt der Datenerhebung (bis zum Jahr 2000 alle 10 Jahre, seit 2010 jährlich), den Ort (landesweit) und die Methode der Datenerhebung.

- Echtzeitdaten vs. historische Daten: Weiterhin können Daten in Echtzeit oder nahezu in Echtzeit erfasst werden, während historische Daten zu einem früheren Zeitpunkt gesammelt wurden. Der Zensus sammelt in der Regel historische Daten. Die Ergebnisse werden jedoch über einen längeren Zeitraum genutzt und aktualisiert, um Trends zu verfolgen.

- Beobachtungsdaten vs. Befragungsdaten: Beobachtungsbasierte Methoden erfassen Daten, indem das Verhalten von Personen oder Ereignisse beobachtet werden, während befragungsbasierte Methoden indirekt Informationen durch direkte Befragung von Personen gewinnen. Bei der Volkszählung werden meist befragungsbasierte Methoden verwendet, bei denen Haushalte und Unternehmen direkt befragt werden, um Informationen bereitzustellen.

- Technologiebasierte vs. manuelle Datenerhebungen: Technologiebasierte Methoden, die Sensoren, IoT-Geräte oder digitale Tools zur Datenerhebung verwenden, unterscheiden sich von manuellen Methoden, die menschliche Eingabe oder Beobachtung erfordern. Die Volkszählung verwendet sowohl technologiebasierte als auch manuelle Methoden. Dabei kann die Datenerhebung sowohl halbautomisiert über das Auslesen von Datenbanken erfolgen oder auf persönliche Befragungen zurückgreifen. Erwähnenswert ist, dass auch Befragungen von technischen Hilfen, wie beispielsweise Online-Fragebögen, profitieren, die den Prozess effizienter und kostengünstiger gestalten.

Bloss beobachten oder einfach experimentieren?

Die Volkszählung des BfS ist ein gutes Beispiel für eine statistische Datenerhebung, die versucht, den Ist-Zustand möglichst genau zu beschreiben, jedoch ohne direkt darauf einzuwirken. Daneben gibt es aber auch die Möglichkeit, ein Experiment durchzuführen, um Daten zu gewinnen. Experimentelle Daten werden unter kontrollierten Bedingungen gesammelt, um Ursache-Wirkungs-Beziehungen zu untersuchen. Beide Arten der Datenerhebung haben ihre Vor- und Nachteile, die insbesondere bei der Analyse und der Interpretation der Daten zu berücksichtigen sind. So ist es mit Beobachtungsstudien viel schwieriger, Kausalzusammenhänge nachzuweisen. Demgegenüber ist es bei experimentellen Studien möglich, mittels Randomisierung, d.h. der zufälligen Zuteilung zu den einzelnen experimentellen Bedingungen, den Einfluss der experimentellen Intervention von anderen möglichen Einflussfaktoren zu trennen.

Ein Beispiel ist die Untersuchung der Auswirkungen von Schlafentzug auf die kognitive Leistungsfähigkeit von Menschen. Die Forschenden teilen dabei eine Gruppe von Probanden zufällig in zwei Gruppen ein: Der ersten Gruppe wird eine Nacht lang der Schlaf entzogen, während die zweite Gruppe eine normale Nachtruhe hat. Anschliessend werden kognitive Leistungstests durchgeführt, um die Auswirkungen des Schlafentzugs zu messen. Weil die Zuteilung der Probanden in eine der beiden Gruppen zufällig erfolgte, kann verhindert werden, dass systematisch z.B. alle besonders intelligenten Teilnehmenden in derselben Gruppe sind.

Weiterhin lassen sich Experimente oft so planen, dass die Genauigkeit der Datenerhebung steigt, sodass auch kleine Effekte und Unterschiede erfasst werden können. Im obigen Beispiel können die Forschenden beispielsweise sicherstellen, dass alle Teilnehmenden in einer Gruppe die gleichen Schlafbedingungen im Schlaflabor haben. Würden die Teilnehmenden stattdessen zu Hause übernachten, wären sie einer Vielzahl ganz unterschiedlicher Einflussfaktoren ausgesetzt, zum Beispiel durch Strassenlampen, Party-Lärm, Temperaturunterschiede usw., welche die Resultate beeinflussen könnten. Das würde die Variabilität der Ergebnisse erhöhen, wodurch es wiederum schwieriger wäre, den Effekt von Schlafentzug auf kognitive Leistungen korrekt zu erfassen.

Experimentelle Studien vereinfachen deshalb auch die Reproduzierbarkeit von Ergebnissen: Indem die Datenerhebungen unter annähernd gleichbleibenden Bedingungen wiederholt werden können, lassen sich bereits erfasste Ergebnisse überprüfen und somit bestätigen oder widerlegen.

Doch gerade die kontrollierten Bedingungen können auch gewisse Nachteile bergen: Weil ein Experiment nicht unter natürlichen, sondern eben unter experimentell kontrollierten Bedingungen stattfindet, lassen sich die erhobenen Ergebnisse nicht direkt auf die Welt ausserhalb des Experiments übertragen. Das ist ein wesentlicher Unterschied zur beschreibenden Datenerhebung, wie sie bei der Volkszählung des Bundesamts für Statistik zur Anwendung kommt. Mit der Volkszählung lassen sich direkt oder indirekt beschreibende Aussagen zur Bevölkerung in der ganzen Schweiz machen, jedoch ohne Kausalbeziehungen feststellen zu können.

Sowohl bei experimentellen wie auch bei beobachtenden Datenerhebungen macht es einen Unterschied, ob sie offen oder verdeckt durchgeführt werden. Im Falle einer offenen Durchführung wissen die Teilnehmenden einer Untersuchung mehr über die Details der Datenerhebung als bei einer verdeckten bzw. verblindeten Durchführung, bei denen bestimmte Informationen vorenthalten werden. Zum Beispiel ist es bei vielen Medikamententests Standard, dass weder die Patienten noch die behandelnden Ärzte wissen, welches Medikament verschrieben wird. So soll verhindert werden, dass das Wissen darüber, welches Medikament verschrieben wird, das Verhalten von Ärzten und Patienten systematisch verzerrt.

Dass eine solche Form der Verblindung nicht immer möglich ist, zeigt das obige Beispiel mit der experimentellen Studie zum Schlafentzug: Die Probanden wissen spätestens nach der ersten Nacht, in welche der beiden Gruppen sie eingeteilt worden sind.

Was hat das alles mit Statistik zu tun?

Statistische Methoden spielen bei der Planung von Datenerhebungen eine zentrale Rolle, wobei es auch hier gewisse Unterschiede zwischen beobachtenden und experimentellen Erhebungen gibt.

Bei beobachtenden Erhebungen stellen sich insbesondere folgende Fragen:

- Wie erfolgt die Auswahl der Stichprobe aus der Gesamtpopulation?

- Aus welchen Quellen stammen die erhobenen Daten?

- Lässt die gewählte Stichprobe Rückschlüsse über die Gesamtpopulation zu?

Bei experimentellen Erhebungen stehen zumeist andere Fragen im Vordergrund:

- Mit welchem Zufallsverfahren werden die experimentellen Gruppen eingeteilt?

- Wie werden systematische Verzerrungen verhindert?

- Wie lassen sich externe Einflussfaktoren reduzieren?

In beiden Fällen ist die Frage zentral, wie gross die Zahl der erhobenen Datenpunkte (Stichprobe) sein muss, um präzise Aussagen über die Grundgesamtheit machen zu können. Ist die Stichprobe zu klein, so lassen sich kaum verlässliche Schlüsse aus der Datenerhebung ziehen. Ist sie zu gross, kostet die Erhebung mehr, als sie müsste.

Die Statistik hat eine Reihe von Verfahren entwickelt, um die obenstehenden Fragen zu adressieren. So beschäftigt sich die sogenannte «Stichprobentheorie» mit der korrekten Auswahl einer Stichprobe aus der Grundgesamtheit. Im Falle der Volkszählung des BfS sind relevante Grundgesamtheiten beispielsweise die Schweizer Bevölkerung, die Gesamtzahl aller Schweizer Haushalte oder die Gesamtzahl aller Schweizer Unternehmen. Ziel der Stichprobentheorie ist es, Methoden zur Stichprobenauswahl bereitzustellen, mit denen sich aus einer Stichprobe Rückschlüsse über die Grundgesamtheit ziehen lassen.

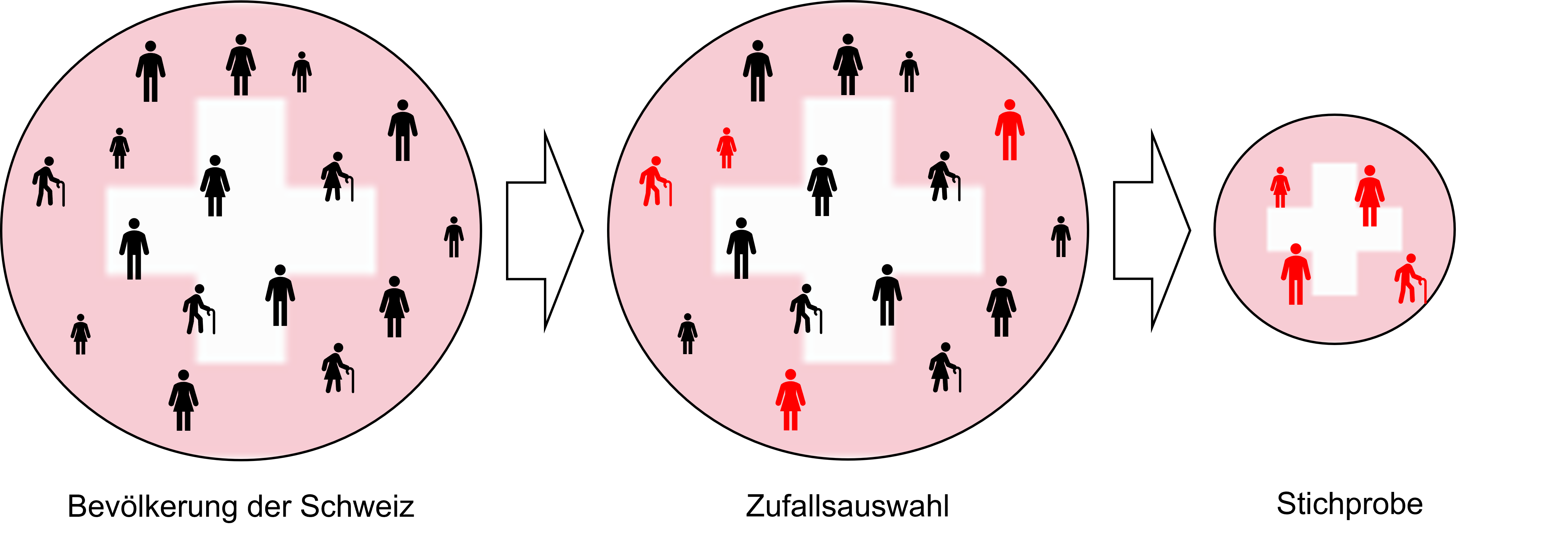

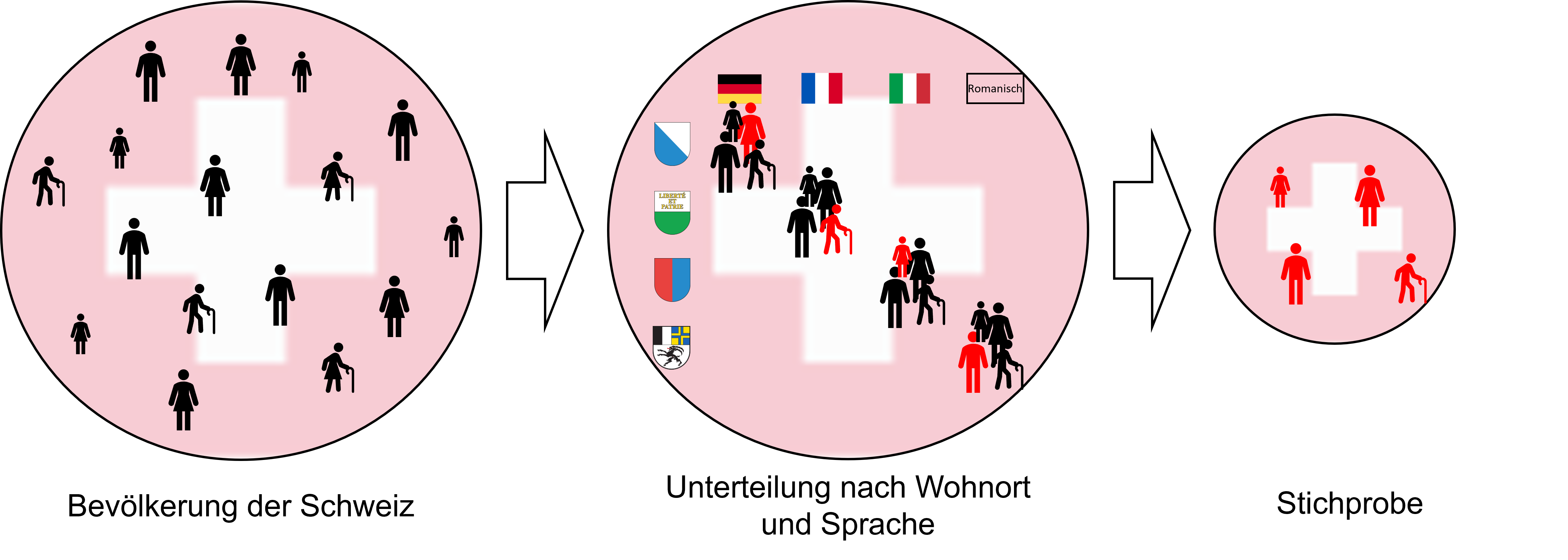

Hierbei gibt es verschiedene Ansätze: Bei einfachen Zufallsstichproben werden, wie in Abbildung 1 skizziert, zufällig einzelne Individuen aus der gesamten Population gezogen. Bei einer stratifizierten Stichprobenerhebung wird die Population zuerst in einzelne Schichten (“strata”) unterteilt, aus denen dann jeweils zufällige Stichproben gezogen werden. Will man beispielsweise sicherstellen, dass alle vier Sprachregionen der Schweiz genügend gut abgebildet sind in der Stichprobe, könnte man die Schweizer Bevölkerung zuerst nach Wohnort unterteilen und dann gesonderte Stichproben aus den deutsch, französisch, italienisch und romanisch sprechenden Landesteilen erheben (Abbildung 2).

Die Berücksichtigung der Stichprobentheorie bei der Datenerhebung ist deshalb wichtig, weil Daten alleine nichts darüber aussagen, ob sie auch Rückschlüsse über die Gesamtpopulation zulassen. Würde das BfS beispielsweise bloss Menschen in Neuenburg befragen, liessen sich die damit gewonnen Informationen nicht auf die ganze Schweiz übertragen.

Bei experimentellen Datenerhebungen ist insbesondere die statistische Versuchsplanung von Bedeutung. Sie gibt beispielsweise vor, wie eine Stichprobe korrekt in verschiedene experimentelle Gruppen eingeteilt und wie Störfaktoren kontrolliert werden. Das korrekte Randomisierungsverfahren, d.h. die zufällige Zuteilung der Stichproben in die experimentellen Gruppen, spielt dabei eine zentrale Rolle. Sie reduziert nämlich das Risiko, dass andere Einflussfaktoren die Resultate systematisch verzerren. Somit steigert sie die Wahrscheinlichkeit, dass Unterschiede in den Ergebnissen zwischen Gruppen tatsächlich auf die unabhängige Variable zurückzuführen sind. Dies ist besonders wichtig, wenn Kausalaussagen getroffen werden sollen.

Zu einer sorgfältigen Datenerhebung gehört aber noch mehr als statistische Theorie. So muss beispielsweise sichergestellt werden, dass die Datenerhebung nicht nur korrekt geplant, sondern auch einwandfrei durchgeführt wird. Ansonsten kommt es zu fehlerhaften Dateneingaben, Ausreissern oder auch fehlenden Daten, welche die nachfolgende Analyse erschweren.

Letztlich ist bei der Interpretation von Daten immer zuerst zu fragen, wie sie erhoben wurden und was sich basierend auf der Erhebungsmethode tatsächlich aus den Daten herauslesen lässt.